ComfyUI是基于节点式流程的开源AI工作流引擎,主打高可控性与模块化,适合需要精细定制生成流程的用户;本地部署提供整合包/桌面版/手动安装三种方式,Windows/Linux/macOS全平台支持;使用以拖拽节点→连接→调参→执行为核心,支持工作流保存复用;核心特点包括可视化流程、性能优异、灵活扩展、完全开源等。

一、ComfyUI是什么

ComfyUI是一个开源、节点式的AI工作流引擎,主要用于Stable Diffusion等扩散模型的可视化创作,同时支持视频、音频和3D生成。它将AI生成的每个环节(加载模型、文本编码、潜空间采样、VAE解码、ControlNet控制等)抽象为独立的"节点",用户通过拖拽连接即可构建自定义流程,无需编写代码就能实现高度复杂的生成任务。

核心定位:区别于Automatic1111 WebUI等"一键生成"工具,ComfyUI更像AI创作的"导演工作台",让用户从被动的参数调整者变为主动的流程设计者,适合专业创作者、研究人员和需要批量处理/复杂控制的用户。

二、本地部署指南

1. 系统要求

显卡方面,最低要求为NVIDIA 4GB显存,推荐配置为NVIDIA 8GB+显存;需要注意的是,AMD显卡需搭配Linux系统使用,无显卡则可采用CPU模式,但生成速度会较慢。内存最低要求8GB,推荐16GB以上,处理大尺寸图像或复杂工作流时需要更多内存支持。存储方面,最低需10GB可用空间,推荐50GB以上,因为单个模型文件大小通常在2-7GB,需预留足够空间存放各类模型。系统支持Windows 10+/Linux/macOS,推荐使用Windows 11或Linux系统,桌面版还支持Windows和macOS(ARM架构)。

2. 三种部署方式(按推荐顺序)

方式1:整合包(新手首选)

首先下载秋叶/星空等整合包,这类整合包已包含Python环境、ComfyUI主程序、常用模型和插件,无需额外下载依赖;将下载后的整合包解压到非中文路径下,例如D:ComfyUI,避免中文路径导致程序报错;解压完成后,运行文件夹内的启动器(如启动器.exe),点击“一键启动”即可;启动成功后,浏览器会自动打开http://localhost:8188,此时便可正常使用ComfyUI。

方式2:官方桌面版(稳定可靠)

访问ComfyUI官方网站,根据自己的操作系统,下载对应的Desktop安装包;下载完成后双击安装包,按照安装向导的提示完成配置,过程中无需手动设置额外参数;安装完成后启动程序,它会自动配置Python环境和所需依赖,无需用户手动操作;启动成功后,支持导入已有的模型和工作流,直接衔接后续使用。

方式3:手动安装(自定义需求)

前置准备:需先安装Python 3.10.x版本,安装时务必勾选“Add Python to PATH”,确保系统能识别Python命令;同时安装Git工具,用于克隆仓库。克隆仓库:打开命令行工具,输入命令git clone https://github.com/comfyanonymous/ComfyUI.git,将ComfyUI仓库克隆到本地。安装依赖:进入克隆后的ComfyUI文件夹(命令cd ComfyUI),然后输入命令pip install -r requirements.txt,安装所有必需的依赖包。下载模型:将Stable Diffusion模型(格式为.ckpt或.safetensors)放入models/checkpoints文件夹中,否则无法正常生成图像。启动程序:根据硬件配置选择对应命令,NVIDIA显卡用户可运行python main.py或双击run_nvidia_gpu.bat;CPU用户双击run_cpu.bat;AMD显卡(仅Linux系统支持)运行run_amd.sh。

3. 模型安装(关键步骤)

不同类型的模型需放入对应文件夹,避免无法识别:检查点模型(主模型,如SD 1.5、SDXL)放入models/checkpoints/文件夹;LoRA模型(用于风格微调)放入models/lora/文件夹;VAE模型(用于解码图像,优化图像质量)放入models/vae/文件夹;ControlNet模型(用于姿态、边缘等精准控制)放入models/controlnet/文件夹。

三、基础使用教程

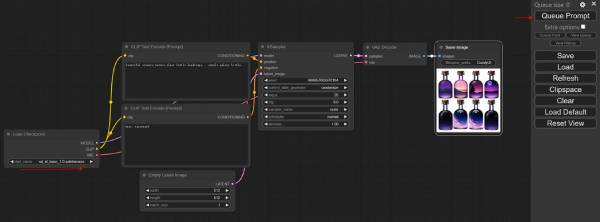

1. 界面概览

ComfyUI界面主要分为四个核心区域:左侧是节点面板,包含所有可用节点,涵盖模型加载、提示词编码、采样生成等全部功能;中间是工作区,是用户拖拽节点、连接节点构建生成流程的核心区域;右侧是队列面板,用于显示等待执行的生成任务,可查看任务进度;底部是输出面板,展示生成的图像结果和历史记录,支持直接下载图像。

2. 快速上手四步法

1. 搭建基础工作流

从左侧节点面板拖拽所需节点,搭建最基础的生成流程,需拖拽的节点包括:Load Checkpoint(加载主模型)、两个CLIP Text Encode(分别用于输入正向提示词和负向提示词)、KSampler(核心采样器,用于生成图像潜空间数据)、VAEDecode(用于将潜空间数据解码为可见图像)、Save Image(用于保存生成的图像结果)。

2. 连接节点

节点连接是实现生成流程的关键,需按以下逻辑连接:将Load Checkpoint节点的model输出,连接到KSampler节点的model输入;将Load Checkpoint节点的clip输出,分别连接到两个CLIP Text Encode节点的clip输入;将正向提示词对应的CLIP Text Encode节点的conditioning输出,连接到KSampler节点的positive输入,负向提示词对应的CLIP Text Encode节点的conditioning输出,连接到KSampler节点的negative输入;将Load Checkpoint节点的vae输出,连接到VAEDecode节点的vae输入;将KSampler节点的latent输出,连接到VAEDecode节点的samples输入;将VAEDecode节点的image输出,连接到Save Image节点的image输入,确保所有节点连接无误,形成完整流程。

3. 设置参数

每个节点需根据需求设置对应参数:模型节点(Load Checkpoint):在节点中选择已安装的主模型;提示词节点(CLIP Text Encode):在正向提示词节点输入图像描述(如“a beautiful sunset over the ocean”),在负向提示词节点输入需避免的内容(如“ugly, blurry, low quality”);KSampler节点:设置采样步数(推荐20-30步)、CFG scale(推荐7)、采样器类型(推荐Euler a,新手易上手)、图像尺寸(推荐512×512,根据显存调整);Save Image节点:设置图像保存路径和文件名,方便后续查找。

4. 执行与查看

参数设置完成后,点击右上角的“Queue Prompt”按钮,启动生成任务;执行过程中,节点会呈现高亮状态,可通过高亮情况了解当前执行进度;生成完成后,底部输出面板会显示生成的图像,点击图像即可直接下载,也可拖拽图像到工作区,用于后续二次编辑或复用。

3. 进阶技巧

工作流管理:按Ctrl+S可保存当前构建的工作流(格式为.json),保存后可分享给他人,或后续再次打开复用,无需重新搭建流程;节点搜索:按Ctrl+F可快速搜索所需节点,避免在众多节点中逐一查找,提升效率;批量生成:使用“Batch Prompt Schedule”节点,可设置多个提示词,实现批量生成多张不同风格或内容的图像;ControlNet集成:添加“ControlNet Apply”节点,连接姿态图、边缘图等参考图,可实现对图像细节的精准控制,让生成结果更符合预期。

四、ComfyUI核心特点

1. 可视化工作流(核心优势)

流程透明:AI生成的每个步骤都以节点形式呈现,全程可见,便于用户调试流程、优化参数,当生成出现问题时,可快速定位出错的节点,无需盲目排查;完全可控:支持多模型串联、多ControlNet叠加、SDXL精炼器等复杂流程,无功能限制,用户可根据创意需求,自由设计专属生成流程;可复用性:工作流保存为文件后,团队协作时可共享使用,确保不同成员使用相同流程,生成结果保持一致,同时支持版本控制,方便后续修改和追溯。

2. 性能与效率

速度优势:相比Automatic1111 WebUI,ComfyUI的生成速度快15-30%,节点式架构能够减少内存占用和计算开销,提升生成效率;智能缓存:当重复执行相同节点时,程序会自动复用之前的执行结果,无需重新计算,大幅提升迭代效率,尤其适合多次调整参数、反复测试的场景;内存优化:具备智能模型加载管理功能,可在显存较小的显卡上运行大型模型,降低硬件门槛。

3. 灵活性与扩展性

模块化设计:每个功能都被设计为独立节点,社区开发者可自由开发新节点,如自定义采样器、图像处理器等,不断丰富功能生态;全模型支持:兼容所有Stable Diffusion生态模型,包括SD 1.5、SD 2.x、SDXL、LoRA、ControlNet、IP-Adapter等,无需额外适配,下载后即可使用;多任务支持:不仅能生成静态图像,还可通过安装插件,实现视频生成(如AnimateDiff)、图像修复、超分辨率放大等多种任务,满足多样化创作需求。

4. 其他优势

完全开源免费:无订阅费用和隐藏成本,代码托管在GitHub上,社区活跃,开发者可自由查看、修改代码,贡献新功能;跨平台支持:全面支持Windows、Linux、macOS三大系统,桌面版进一步简化了安装流程,降低了使用门槛;无侵入性:可与Automatic1111 WebUI共存,两者可共享模型文件,无需重复下载,节省存储空间。

五、适用场景与对比

新手/快速出图用户,推荐选择Automatic1111 WebUI,原因是其操作简单,支持一键生成,学习成本低,无需搭建复杂流程,适合快速获取图像结果;专业创作者/设计师,推荐选择ComfyUI,因为其可控性强,支持复杂创意实现,工作流可复用,能满足精细化创作需求;研究人员/开发者,推荐选择ComfyUI,便于调试新模型、新流程,同时支持自定义节点,可灵活适配研究需求;需要批量处理或自动化生成的用户,推荐选择ComfyUI,可设计批量工作流,结合脚本实现自动化生成,提升工作效率;团队协作场景,推荐选择ComfyUI,工作流文件便于团队成员共享,能确保所有人使用相同流程,保证生成结果的一致性。

本资讯来自互联网,如有侵权强联系删除!